AIの急速な進歩は、主にAIモデルの規模と複雑性の指数関数的な増大によって推進されてきました。過去10年間で、AIモデルは比較的単純なアルゴリズムから、かつてない機能を備えた複雑な大規模言語モデル(LLM)アーキテクチャへと進化しました。しかし、AIはもはやLLMに限定されず、多くの分野に適用され、多様なワークロードを生み出しています。ワークロードの多様化に伴い、インフラストラクチャも多様化する必要があります。つまり、「万能型」のデータセンターインフラストラクチャでは不十分であり、各ワークロードには固有の要件が存在するからです。

カスタマイズの主なメリット

AIデータセンターのカスタマイズは、もはやコンピューティング要素(XPUなど)のカスタマイズだけでなく、AIサーバーやラック内のすべてのコンポーネントをカスタマイズすることも可能になります。インフラストラクチャのカスタマイズの主なメリットは次のとおりです。

・パフォーマンス最適化 – LLMのトレーニングや大規模な推論実行は、高度に専門化されたタスクです。カスタムシリコンは、行列乗算(ニューラルネットワークで使用)、スパース計算、低精度演算(FP8、INT4など)といった特定の演算に合わせて調整できます。

・AIモデルの急速な進化 – AIモデルのアーキテクチャは急速に進化しています。カスタムシリコンは特定のアルゴリズム向けに設計できるため、汎用チップと比較してパフォーマンスが向上します。

・電力効率と熱効率の向上 – 大規模なAIワークロードを実行するデータセンターは膨大な量のエネルギーを消費します。特定のワークロード向けに設計されたカスタムシリコンは、ワットあたりのパフォーマンス効率を向上させます(ハイパースケーラーによると最大30%向上)。これにより、消費電力と冷却要件が軽減されます。

・総所有コスト(ToC)の削減 – カスタムシリコンチップは初期コストが高いものの、電力効率と熱効率の向上に加え、パフォーマンス/スループットの向上により、長期的にはToCが削減されます。特に、大規模なAIワークロードを大規模に実行する大手ハイパースケーラーの場合、その効果は顕著です。

・差別化と競争優位性 – ハイパースケーラーは、AIサービスを差別化し、独自のハードウェア/ソフトウェアスタックを開発したいと考えています。カスタムシリコンには、顧客の要件に合わせて特別に設計されたメモリ暗号化などの特殊なセキュリティ機能も組み込むことができます。

【カスタムシリコンの可能性】

現代のAIインフラストラクチャでは、AIワークロードを大規模に実行するためのシリコンを備えた完全なプラットフォームが必要です。カスタムXPUに加えて、AIアクセラレーションコンピューティングプラットフォームには、XPUをサポートおよび拡張するためのXPUアタッチチップと呼ばれる多数のコンパニオンチップが必要です。例としては、ネットワークインターフェースカード(NIC)、電源管理IC、セキュリティおよびホスト管理用の専用コプロセッサ、メモリプーラー/エクスパンダーなどが挙げられます。

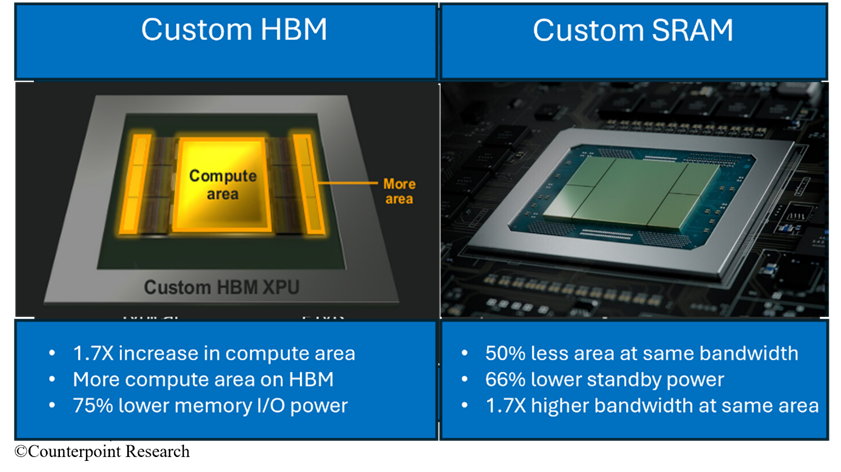

XPUには、コアアーキテクチャ、コア数、コアとメモリの比率、必要な精度レベル(FP16、FP8、FP4など)など、複数のカスタマイズオプションがあります。カスタマイズに適したもう1つの主要コンポーネントはメモリです。メモリは長年、標準規格に厳密に準拠してきました。しかし、膨大なメモリと帯域幅を必要とするAIは、この状況を変えつつあります。Marvellは最近、AIデータセンター向けのカスタマイズされたHBMおよびSRAMチップに関する2つの重要な発表を行いました。

【カスタマイズされたHBM】

HBMはXPUの重要なコンポーネントであり、総コストの約40%を占めています。現在のHBMは、JEDECベースのインターフェースを採用したI/Oメモリを搭載しており、通常は32個の64ビットチャネルで構成されています。しかし、Marvellは、より小型で最適化されたインターフェースを採用したカスタムHBMコンピューティングアーキテクチャを開発しました(図1、左)。これにより、各ダイのシリコン面積が削減され、HBMサポートロジックをベースダイに統合することが可能になります。

MarvellのカスタマイズされたHBMソリューションは、XPUのパフォーマンスを向上させると同時に、標準的なJEDECベースのインターフェースと比較してインターフェースの消費電力を75%削減します。HBMのサイズを縮小することで、面積も25%増加します。お客様は、この削減分を活用して、XPUあたりのコンピューティングメモリやHBMメモリを増設したり、新機能を追加したりすることができます。

【カスタムSRAM】

ファウンドリやIPプロバイダーから供給されるSRAMメモリチップは、XPU内部で非常に大きな面積(通常、最大40%)を占めます。Marvellは6月に、業界初の2nmカスタムSRAMチップを発表しました。このチップは、市販チップと比較して、同じ帯域幅で占有面積を50%削減します(図1、右)。このチップは、データセンターに最大限の帯域幅を提供するように最適化されており、他のチップと比較して1mm²あたりの帯域幅が17倍に増加しています。また、スタンバイ電力も66%低減しています。MarvellのカスタムSRAMチップにより、お客様はXPUでより多くのSRAMを使用でき、同じ消費電力でより多くのコンピューティング能力を発揮できるようになります。

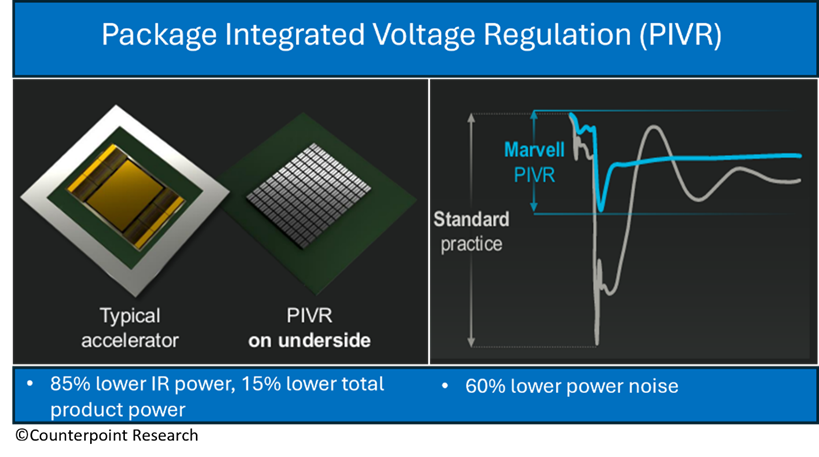

【パッケージ統合電圧レギュレーション(PIVR)】

カスタムシリコンのもう一つの興味深い例として、Marvellのオンパッケージ統合電圧レギュレーションチップ(PIVR)が挙げられます。PCBに沿ってアクセラレータチップに電力を供給すると、通常、大きな電力損失と非効率性が伴います。PIVRチップは、プロセッサチップから数インチ離れた独立したチップではなく、プロセッサチップ自体の下に統合されています(図2、左)。これにより、伝送損失が大幅に低減されると同時に、プロセッサへの電力供給量が増加します。パッケージ統合電圧レギュレーションにより、MarvellのPIVRチップは電力損失を85%削減すると同時に、製品全体の消費電力を15%削減します。さらに、PIVRチップは電源ノイズを60%低減します(図2、右)。電力供給の高密度化により、ラックあたりのコンピューティング能力が向上し、ひいてはデータセンター事業者のROI(投資収益率)の向上につながります。

【Marvellのソケット受注】

Marvellは現在、18件のカスタムシリコンソケット受注を獲得しています(カスタムXPU 5件、カスタムアタッチ12件)。カスタムXPUは1つあたり数十億ドル規模のビジネスチャンスであり、通常18~24か月のライフサイクルを誇ります。一方、XPUのアタッチは2~4年で数百万ドル規模のビジネスチャンスとなります。Marvellは現在、10社の潜在顧客を対象に、約50件以上のビジネスチャンスを評価しています。これらのビジネスチャンスの約3分の1はXPU関連、残りはXPUアタッチ関連です。Marvellは、AIデータセンター向けシリコン市場で20%のシェア獲得を目指しており、2028年までにその市場規模は180億ドル以上に達したいと考えています。

【エコシステムにおけるビジネスチャンス】

カスタムシリコンコンポーネントに関する発表に加え、Marvellは最近、2つの戦略的なエコシステムに関する発表を行いました。まず、NVIDIAのNVLink Fusionイニシアチブへの参加を発表しました。その後まもなく、同社はUltra Accelerator Link(UALink)規格に基づくカスタマイズ可能なコンピューティングプラットフォームの開発を発表しました。

NVIDIAのNVLink Fusionは、NVIDIAのNVLinkコンピューティングファブリックとラックアーキテクチャの一部をサードパーティ製チップに開放することで、パートナー企業がNVIDIAのBlackwell GPUやGrace CPUと同じシステムにカスタムチップをシームレスに統合できるようにします。これにより、カスタムXPUを使用することで、AIファクトリーを数百万台のアクセラレータに迅速に拡張できます。また、パートナー企業は独自のカスタムCPUをNVIDIAのGPUラックシステムに接続することも可能です。

UALink – Marvellは、224G SerDesとUALink物理層IPに加え、特定のハードウェア構成や性能/消費電力目標に合わせて最適化された幅広い高度なパッケージオプションを備えた、カスタマイズ可能なUALinkスケールアップソリューションを開発しました。UALinkは性能面ではNVLinkと競合しますが、ハイパースケールAIインフラストラクチャにオープンスタンダードとマルチベンダー対応の柔軟性をもたらします。これにより、お客様は単一のポッドで最大1,024台のコヒーレント接続アクセラレータをスケールアップ接続することが可能になります。

【アナリストの視点】

AIデータセンター・インフラストラクチャにおけるカスタマイズのトレンドは明確であり、特に大手企業の間で加速しています。実際、カスタマイズは、AIを大規模に導入するあらゆる企業にとって戦略的に不可欠なものになりつつあります。なぜなら、カスタマイズは最適なワット性能を実現すると同時に、イノベーション、セキュリティ、エコシステムのサプライチェーンをより適切に管理することを可能にするからです。カスタムシリコンはもはやコンピューティングに限定されず、インターコネクト、電源コンポーネント、スイッチ、ストレージ、セキュリティなど、事実上すべてのコンポーネントを網羅しており、ハイパースケーラーやその他のAIインフラストラクチャ企業は、垂直最適化された高性能でエネルギー効率の高いAIファクトリーを構築できます。

しかし、カスタムAIシリコンの開発には、複数の分野にわたる深い専門知識が必要であり、ベンダーは技術、戦略、運用の幅広い要件を満たす必要があります。クラウドに最適化されたシリコンの時代において、フルサービスのパートナーと連携することが不可欠です。 MarvellのAI戦略は、SerDes、Die-to-Die(D2D)インターコネクト、高度なパッケージングといった重要な技術におけるコアIPを活用し、データセンター市場の主要企業と連携してカスタム製品・ソリューションを開発することに基盤を置いています。実際、Marvellは幅広いカスタムシリコン製品・サービスをワンストップで提供しています。つまり、顧客はサードパーティ企業からIPを集約したり、社内チームを補完するために設計会社を雇ったり、サプライチェーン管理のためにベンダーを探したりする必要がないということです。

カウンターポイントリサーチは、Marvellによる最近のNVLinkおよびUALinkに関する発表は戦略的に重要であり、加速型カスタムAIインフラストラクチャにおける主要な「頼れる」シリコンプロバイダーとしての同社の地位を強化すると考えています。NVLink FusionをMarvellのカスタムクラウドシリコンに統合することで、Marvellは既にNvidiaのラックシステムを使用しているクラウドプロバイダーにとって「すぐに使える」サプライヤーとなります。これにより、同社は新規設計・統合案件の受注獲得において優位な立場を確立するとともに、カスタマイズ可能なUALink IPソリューションにより、オープンスタンダードを活用した次世代AIインフラの主要なイネーブラーおよびインテグレーターとしての地位を確立します。

これらの取り組みをサポートすることで、Marvellはデータセンターのカスタムシリコを巧みに拡大します。

【カウンターポイントリサーチについて】

カウンターポイントリサーチは、テクノロジーエコシステム全体を対象とした製品を専門とするグローバルな市場調査会社です。

当社は、世界中の主要なイノベーション・ハブ、製造クラスター、商業都市に拠点を構え、スマートフォンOEMからチップメーカー、チャネル企業、大手テクノロジー企業に至るまで、幅広いクライアントにサービスを提供しています。

経験豊富な専門家が率いるアナリストチームは、企業の経営幹部、戦略担当者、アナリストリレーション(AR)、市場情報(MI)、ビジネスインテリジェンス(BI)、製品およびマーケティングの各部門のステークホルダーと連携しながら、市場データ、インサイト、コンサルティングなど幅広いサービスを提供しています。

当社の注力分野には、AI、自動車、コンシューマーエレクトロニクス、ディスプレイ、eSIM、IoT、位置情報プラットフォーム、マクロ経済、製造、ネットワークインフラ、半導体、スマートフォン、ウェアラブルなどが含まれます。

公開中の市場データ、インサイト、ソートリーダーシップについては、当社ウェブサイトの「Insights」ページをご覧ください。重点分野についてより深くご理解いただくためにも、ぜひアナリストと直接ご相談いただければと思います。